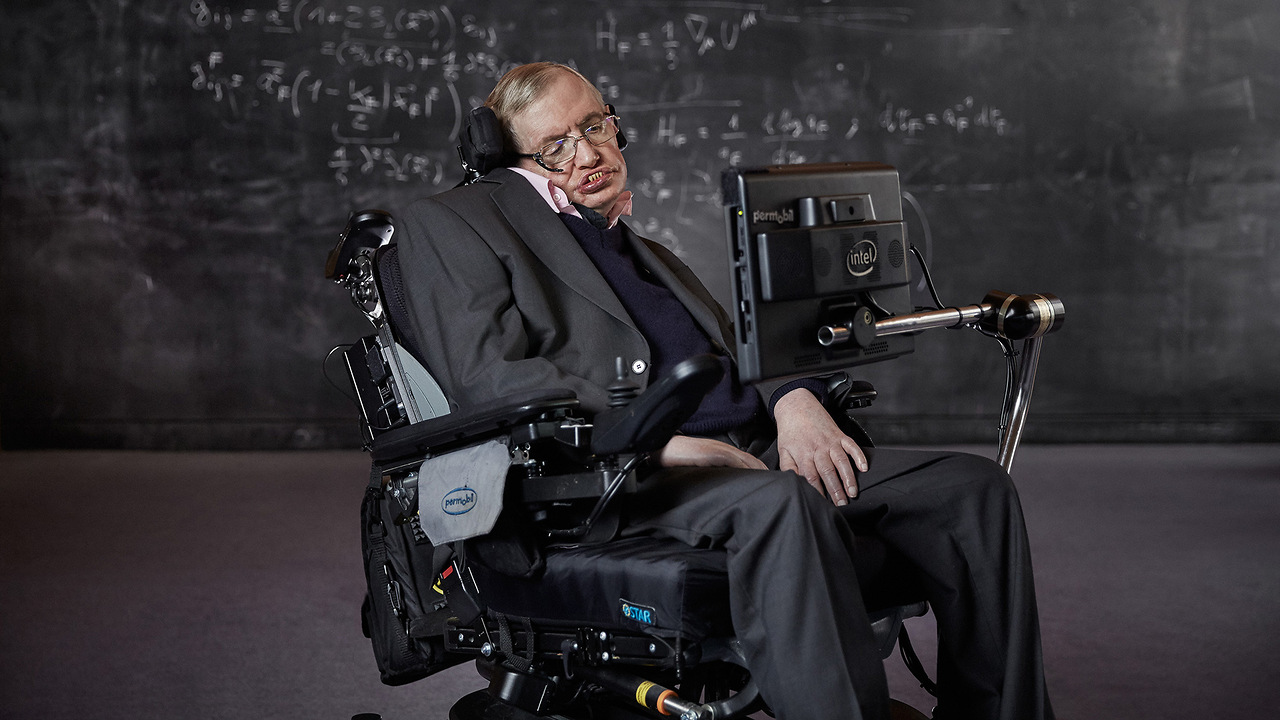

Хокинг предупреждал: развитие ИИ ведет к угрозе существованию людей как вида

Стивен Хокинг предупреждал, что главные риски для будущего человечества связаны не с космическими катастрофами, а с деятельностью людей.

Задолго до смерти он называл среди ключевых угроз ядерные конфликты, создание опасных биологических вирусов и климатические изменения, вызванные человеческой активностью. По его мнению, эти факторы способны поставить под сомнение дальнейшее существование цивилизации.

Физик полагал, что человечество не сможет бесконечно оставаться в пределах одной планеты и должно осваивать космос. В ближайшие десятилетия, считал он, необходимо создавать постоянные внеземные поселения не в формате небольших научных баз, а колоний, рассчитанных на жизнь тысяч людей, а также содержание животных и растений. В качестве основных направлений он выделял Луну и Марс и предупреждал, что затягивание начала таких проектов чревато серьёзными последствиями.

Хокинг допускал существование развитых инопланетных цивилизаций и говорил о рисках прямого контакта с ними, указывая на возможность серьёзного ущерба для человечества в случае технологического превосходства пришельцев.

Особую обеспокоенность у учёного вызывало развитие искусственного интеллекта. Он считал, что системы, способные к саморазвитию, могут превзойти человека и вытеснить его как доминирующий вид. К числу сопоставимых по масштабу угроз он относил глубокую генетическую модификацию людей и появление «сверхлюдей», что, по его оценке, может привести к исчезновению обычного человечества или превращению его в зависимую и социально уязвимую группу.

Хокинг настаивал, что его выводы основаны на анализе тенденций научно-технического прогресса и должны рассматриваться как предупреждение и повод уже сейчас задуматься о будущем цивилизации.